Así se conoce a la aplicación de nuevas tecnologías para la adquisición e interpretación automática de grandes colecciones de datos.

El Big Data es un concepto que ha venido ganando importancia en los últimos tiempos por su gran utilidad en diversos campos. Pero, ¿qué es exactamente y cuáles son sus aplicaciones?

Se trata de la denominación genérica que ha recibido en la industria y la academia la aplicación de nuevas tecnologías para la adquisición, preparación, representación, exploración, análisis e interpretación automática de grandes colecciones de datos; usualmente heterogéneos y cuya aplicación no puede llevarse a cabo mediante las técnicas “tradicionales” de procesamiento del campo de la computación. Dichas técnicas —entre las que se encuentran las bases de datos relacionales (SQL) y los sistemas de cómputo centralizado— se han utilizado durante mucho tiempo pero resultan ineficaces a la hora de trabajar con grandes volúmenes de datos.

El concepto de Big Data suele abarcar, además, la extracción de información pertinente, así como la visualización y presentación de los resultados obtenidos a partir de las tareas de procesamiento, los cuales tienen por objeto soportar la toma de decisiones estratégicas en grandes organizaciones. Este uso creciente ha permitido la extensión y popularización del término que, en sí mismo, no es completamente formal.

Recursos necesarios

El procesamiento de las enormes cantidades de información que caracterizan el Big Data requiere una potente infraestructura computacional, especialmente en materia de recursos para el almacenamiento de datos, procesamiento de alto desempeño (velocidad de cómputo, paralelización de procesos) y transferencia de información entre equipos (conectividad mediante redes de alta velocidad).

Asimismo, es necesario contar con los métodos y procedimientos que permitan usar tales recursos para optimizar la validez y pertinencia de la información obtenida, así como para garantizar la rapidez en la obtención de dichos resultados. Esto último implica el uso inteligente e intensivo de conceptos y herramientas formales de la estadística inferencial, el cálculo de probabilidades, el álgebra lineal, la inteligencia artificial (en áreas como el aprendizaje de máquina, el reconocimiento de patrones, etc.), la computación de alto desempeño (modelos de cómputo paralelo y distribuido) y los métodos numéricos que implementan soluciones aproximadas a ese tipo de problemas.

La convergencia de tales conceptos y herramientas da lugar al nacimiento del campo denominado data science (ciencia de los datos), que involucra la formación de personal con altos niveles de conocimiento en las áreas mencionadas y cuyo ejercicio tiende a materializarse en la disciplina conocida como data analytics (analítica de datos). Esta disciplina busca la interpretación estadísticamente válida de información pertinente extraída a partir del procesamiento de los datos agregados de diferentes fuentes; tal pertinencia se define según los objetivos, necesidades y expectativas de una organización determinada. En contextos técnicos, empiezan a preferirse estos dos términos (data science y data analytics) para referirse a los campos y aplicaciones relacionados.

Clasificación

Dado que el término Big Data es reciente, no existe una definición única y estricta. De ahí que haya múltiples clasificaciones que dependen del autor que las proponga y, específicamente, de las características, procesos, objetivos y enfoques propios de cada una de las aplicaciones de las grandes colecciones de datos.

Según algunos autores (entre ellos Michael Kanellos, de Forbes), las aplicaciones que implementan conceptos, procesos y tareas relacionados con el Big Data se pueden clasificar así:

- Analítica de grandes volúmenes de datos: abarca los problemas clásicos de detección y extracción de patrones que, según sus características y regularidades, configuran información relevante para el usuario o la organización. Su obtención solo es posible mediante la exploración de enormes colecciones de datos que contienen dicha información de manera no explícita. En este frente prima la exhaustividad de los resultados.

- Obtención rápida de información crítica: comprende la identificación de tendencias, oportunidades o riesgos cuyo conocimiento preciso y oportuno conduciría a una mejora estratégica de la situación de la organización, si bien su detección implica el procesamiento ágildde grandes cantidades de datos. Estas tareas requieren rapidez y precisión.

- Extracción de información compleja: busca el procesamiento de la información contenida en los datos, pero de difícil extracción dada su complejidad (por ejemplo, las acciones en un video, los patrones existentes en imágenes o las medidas arrojadas por múltiples sensores). En este caso, el énfasis se pone en la representación y caracterización de la información buscada.

- Extracción de información de difícil acceso: es la información contenida en múltiples fuentes de diferente tipo y de baja agregación, como la proveniente de sensores de seguridad, medidas de equipos industriales, etc. Su uso requiere concentrar los esfuerzos en la propia adquisición de los datos.

- Uso de información de actualización rápida y continua: se refiere a los datos masivos adquiridos en tiempo real. En este caso, la atención se centra en el desempeño de los algoritmos.

Campos de aplicación

El concepto de Big Data ha tenido gran difusión en tiempos recientes debido al alto impacto de la analítica de datos masivos en la toma de decisiones estratégicas en empresas y organizaciones que producen, gestionan y requieren grandes volúmenes de datos para optimizar su operación con miras a la consecución de resultados misionales o estratégicos.

Así, en ambientes empresariales es común encontrar aplicaciones de Big Data en áreas tales como:

- Análisis de tendencias de los mercados

- Caracterización de gustos y preferencias de clientes actuales y potenciales

- Diseño de estrategias publicitarias focalizadas

- Definición de poblaciones objetivo

- Diseño de productos y servicios según grupos de interés identificados en el entorno

- Determinación de oportunidades de negocio y estrategias de inversión

- Análisis de riesgos

Del mismo modo, en campos de desarrollo tecnológico se empiezan a hacer más comunes aplicaciones de análisis de datos masivos recolectados de múltiples fuentes.

La necesidad de trabajar con grandes volúmenes de datos se remonta a los orígenes mismos de la computación. Sin embargo, el paso de los conjuntos de datos homogéneos, fuertemente estructurados y aplicados a conjuntos limitados, al manejo de colecciones datos heterogéneos, de crecimiento acelerado y baja estructuración (como es el caso de la búsqueda cotidiana de sitios web mediante palabras clave a través de “buscadores” modernos como Google) constituye un salto tecnológico relativamente notorio.

Podría decirse que en los inicios de lo que hoy conocemos como Big Data está el desarrollo de algoritmos que permiten la obtención, cada vez más completa, precisa y rápida, de enlaces a un gran número de documentos en la web. Este hecho dio origen al concepto de “buscador”, campo en el cual se ha presentado una especie de “selección natural” dada por dichos criterios y que ha permitido que Google y Yahoo se mantengan como líderes.

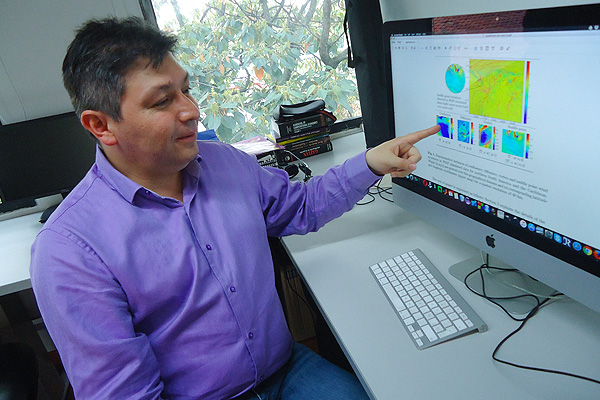

¿Qué debe hacer un estudiante que quiera desarrollar su carrera en este campo?

Como en todas las disciplinas, quien esté interesado en convertirse en un data scientist (científico de datos) o dedicarse a líneas profesionales similares, debe asumir con mucha motivación y concentración su formación en los componentes fundamentales de su carrera. En este caso se debe prestar especial atención a las áreas relacionadas con las matemáticas (cálculo real, álgebra lineal, ecuaciones diferenciales, cálculo de probabilidades, estadística inferencial, etc.) y computación (programación, análisis de algoritmos, ingeniería de software, arquitectura de sistemas, sistemas distribuidos, etc.). Asimismo, es necesario demostrar curiosidad y dedicación al estudio de áreas aplicadas de desarrollo más recientes en el campo, tales como el aprendizaje de máquina, el reconocimiento de patrones y la analítica de datos, entre otras.

Para este último efecto, además de cursar los contenidos propios de las asignaturas formales que se imparten en los programas, también es necesario hacer un uso intensivo de la información disponible en internet; esta abarca textos, tutoriales, explicaciones, artículos e incluso cursos y especializaciones completas en plataformas de formación en línea como Coursera, que han alcanzado altos niveles de calidad gracias al prestigio de los profesores e instituciones que las respaldan.

En todos los casos, es importante encontrar espacios de aplicación práctica de los conocimientos teóricos adquiridos; para ello, los interesados pueden ponerse en contacto con los equipos que desarrollan proyectos de investigación en el área.